Galadrim

Votre équipe web, mobile, IA

Votre équipe web, mobile, IA

Découvrez les meilleures agences Data Vizualisation en France, soigneusement sélectionnées pour leur expertise et leur maîtrise des enjeux propres à la visualisation de données. Opter pour une agence française spécialisée, c’est bénéficier non seulement de compétences techniques pointues, mais aussi d’une réelle compréhension du contexte local et sectoriel. La Fabrique du Net met à votre disposition une sélection rigoureuse des acteurs les plus qualifiés du marché, capables de transformer vos données en leviers stratégiques et visuels percutants. En parcourant notre liste, vous trouverez des partenaires de confiance, à même de répondre à vos besoins spécifiques et de vous accompagner vers des solutions innovantes et sur-mesure. Explorez notre sélection pour identifier l’agence qui saura révéler tout le potentiel de vos données.

Votre équipe web, mobile, IA

Votre équipe web, mobile, IA

Partenaire de votre transformation Data & IA

Partenaire de votre transformation Data & IA

Ismail M.

Lead Data Engineering - Data Platform Team • Accor

01/2026

Manuel D.

CTO • Madkudu

01/2026

Adrien P.

CTO • Citron

01/2026

Culture / Médias / Divertissement

Contexte et enjeux Notre client, une maison de vente aux enchères de renom, devait relever d’importants défis dans la ge...

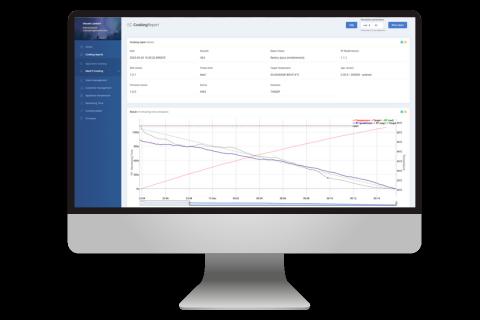

Industrie / Énergie / Ingénierie

Contexte Notre client met au point une solution pour digitaliser la gestion énergétique et technique des biens immobilie...

Tourisme / Hôtellerie / Restauration

Objectif de la mission Les dispositifs de fidélité constituent un levier puissant pour une marque, permettant de valoris...

Vous avez du mal à choisir votre agence ? Laissez-nous vous aider gratuitement

CRM, IT, DATA, IA

CRM, IT, DATA, IA

.jpeg)

Thibaut P.

Gérant • Numenys

12/2025

Services B2B / SaaS / Logiciels

Présentation du projet Mirakl, entreprise experte dans les solutions de marketplace, recherchait une amélioration signif...

Immobilier / Construction / BTP / Mode / Luxe / Beauté

Barnes International : Étude Marketing Automation Barnes International, agence immobilière de prestige, a été accompagné...

Hyperstack accompagne les entreprises à devenir plus performantes et data-driven grâce au no-code, à la data et à l’IA.

Hyperstack accompagne les entreprises à devenir plus performantes et data-driven grâce au no-code, à la data et à l’IA.

Benjamin P.

Ben&Vic

09/2025

Formation / Coaching / RH

One Learn forme des professionnels autour de l’architecture et du design, avec une activité en forte croissance.Pour mie...

Services B2B / SaaS / Logiciels

Copernic souhaitait disposer d’une infrastructure data robuste afin de centraliser ses données Divalto, d’améliorer leur...

Économie sociale / ONG / ESS

Grâce à une transformation technique en profondeur, Agoterra bénéficie désormais d’un back-end solide, automatisé et évo...

Retail / E-commerce / Consommation

Grâce à une automatisation complète du traitement de ses commandes en ligne, SVR dispose désormais d’un flux de données...

Des experts augmentés par l'intelligence collective.

Des experts augmentés par l'intelligence collective.

Gagnez du temps, boostez vos résultats, innovez durablement. USTS, 10 ans d’expertise au service de vos ambitions digitales

Gagnez du temps, boostez vos résultats, innovez durablement. USTS, 10 ans d’expertise au service de vos ambitions digitales

Virtuous Innovators

Virtuous Innovators

Services publics / Éducation

Problème Automatisation des données : informations dispersées L'absence d'automatisation empêche d’obtenir de la visibil...

Industrie / Énergie / Ingénierie / Mode / Luxe / Beauté

Mission : Un acteur du secteur de la parfumerie souhaitait dépasser les limites des solutions AMDIS et Excel pour analys...

We are Eurelis, Smart Applications Maker !

We are Eurelis, Smart Applications Maker !

Industrie / Énergie / Ingénierie

Eurelis accompagne Kestrel Vision, leader mondial des systèmes de contrôle et d’inspection industriels, dans la migratio...

Industrie / Énergie / Ingénierie

Eurelis accompagne Mastrad, marque française reconnue d’ustensiles de cuisine innovants, dans la conception, le développ...

Inkidata, institut d’études marketing à Lyon

Inkidata, institut d’études marketing à Lyon

🚀 Solutions Digitales Sur-Mesure pour les PME et ETI

🚀 Solutions Digitales Sur-Mesure pour les PME et ETI

Une IA transparente, fiable et explicable pour optimiser vos processus métier

Une IA transparente, fiable et explicable pour optimiser vos processus métier

De l’UX à l’IA, un partenaire digital sur toute la chaîne.

De l’UX à l’IA, un partenaire digital sur toute la chaîne.

Capt IA Optimisez l’humain, automatisez l’essentiel

Capt IA Optimisez l’humain, automatisez l’essentiel

-thumb.jpg)

SLAP digital est une agence FR spécialisée sur les problématiques d'acquisition (SEA/SEO/GEO/SMA/Analytics) et d'écosystème digital (Sites, PIM, DAM).

SLAP digital est une agence FR spécialisée sur les problématiques d'acquisition (SEA/SEO/GEO/SMA/Analytics) et d'écosystème digital (Sites, PIM, DAM).

Agence intelligence artificielle, machine learning et data. Experts du développement d'IA sur mesure, ou à partir d'un modèle existant.

Agence intelligence artificielle, machine learning et data. Experts du développement d'IA sur mesure, ou à partir d'un modèle existant.

DreamOnTech vous propulse au-delà de l'imagination !

DreamOnTech vous propulse au-delà de l'imagination !

Nous explorons et développons vos terres inconnues.

Nous explorons et développons vos terres inconnues.

"Agence RP & influence — créer de l’engagement et valoriser votre marque."

"Agence RP & influence — créer de l’engagement et valoriser votre marque."

Rapprochez-vous du lancement de votre prochain projet dès aujourd'hui

Notre méthodologie repose sur des critères objectifs et vérifiables pour garantir la pertinence de nos recommandations.

Voir la méthodologie détailléeClassement impartial basé sur la data. Aucune agence ne paie pour sa note.

Identité légale, santé financière et expertises sont auditées par notre équipe.

Nous modérons les avis pour filtrer les faux témoignages et garantir l'authenticité.

Découvrez les dernières réalisations des meilleures agences

Energie

Contexte Notre client met au point une solution pour digitaliser la gestion énergétique et technique des biens immobiliers. En s’appuyant sur une plateforme Big Data couplée à l’IoT, il propose à ses clients une optimisation avancée des performances aussi bien système qu’environnementales. Traitant plusieurs centaines de gigaoctets issus de capteurs, l’entreprise avait besoin d’une infrastructure solide, capable de fournir des analyses embarquées en temps réel tout en préservant une expérience utilisateur fluide et intuitive. Enjeux Proposer des analyses instantanées des données IoT afin de permettre une gestion précise des consommations énergétiques. Offrir une expérience utilisateur optimale en mettant à disposition un tableau de bord personnalisé, intuitif et ergonomique pour chaque client. Gérer efficacement de grands volumes de données tout en maintenant performance et rapidité. Garantir la robustesse et la scalabilité de l’infrastructure face à l’augmentation croissante des flux de données. La solution Notre démarche s’est articulée autour d’étapes structurantes pour répondre aux objectifs du client : Définition de l’architecture cloud data Après une analyse approfondie des besoins métiers et des attentes relatives aux données, nous avons conçu une architecture évolutive et performante. Le choix s’est porté sur ClickHouse, célèbre base de données colonne pour sa rapidité et son efficience dans le traitement de requêtes analytiques de grande envergure sur des flux en streaming. Mise en œuvre des pipelines d’ingestion Des pipelines dédiés à l’ingestion des données IoT ont été déployés avec Apache Airflow afin d’assurer l’orchestration du traitement des flux en temps réel. Les données issues de MongoDB sont déclenchées par des triggers, traitées, stockées sur AWS S3, puis transférées dans ClickHouse. Transformation et modélisation des données Une fois collectées, les données suivent différentes phases de stockage : Données RAW : elles sont normalisées, dédupliquées et mises en qualité, avec une politique de rétention adaptée. Entrepôt de données (warehouse) : gestion de l’historique, du versionnement et intégration avec d’autres référentiels. Datamarts : création de tables segmentées par client, favorisant une analyse détaillée des usages. Développement de tableaux de bord interactifs Après transformation des données, nous avons créé une interface intuitive pour restituer l’information à travers Cumul.io. Les clients consultent en temps réel leurs indicateurs de consommation énergétique afin de superviser et piloter efficacement leurs actifs. Résultats obtenus Accès à des analyses IoT en temps réel, favorisant des décisions plus éclairées. Un cockpit adapté à chaque utilisateur, simplifiant le suivi et l’amélioration des consommations. Une plateforme performante et évolutive, capable de gérer de larges volumes de données sans perte de performance. Une forte amélioration de l’ergonomie, grâce à des interfaces intuitives et adaptées aux besoins des clients. Stack technique Base de données : ClickHouse Orchestration : Apache Airflow Stockage : AWS S3 Ingestion de données : MongoDB, Python, SQL Visualisation : Cumul.io

Parfumsplus

Mission : Un acteur du secteur de la parfumerie souhaitait dépasser les limites des solutions AMDIS et Excel pour analyser ses données GC-MS et accélérer la reformulation de ses fragrances. Pour répondre à ce besoin, nous avons conçu une plateforme d’intelligence artificielle spécialement dédiée à la parfumerie. Celle-ci centralise les bibliothèques de molécules et matières naturelles, génère une formule globale polaire/apolaire, permet la superposition des chromatogrammes de marché et d’essai, et offre un module de redosage incluant des coefficients de réponse. Grâce à cette approche unifiée, analyse et reformulation sont désormais réunies au sein d’un même outil, sans utilisation de tableurs, avec une traçabilité totale et des données prêtes à alimenter des modèles d’IA. Ce projet démontre concrètement l’apport de l’IA appliquée au GC-MS dans l’évolution de la formulation de parfums et l’optimisation du travail des analystes. Problématique : Chez Parfumsplus, les équipes d’analyse travaillaient avec une succession d’outils non connectés — principalement AMDIS pour l’analyse GC-MS, et Excel pour la formulation et le redosage. Ce fonctionnement engendrait une perte de temps due aux ajustements manuels, un déficit de traçabilité des choix réalisés, ainsi qu’une impossibilité de standardiser les étapes de reformulation. Chaque analyste appliquait alors ses propres méthodes, avec un risque élevé d’erreurs ou d’incohérences. Objectifs : Le client visait à remplacer cette organisation morcelée par une plateforme unifiée capable de centraliser toutes les librairies de molécules et matières naturelles, de générer automatiquement une formule globale T/TA, d’intégrer un module de redosage basé sur des marqueurs et des coefficients de réponse, de comparer visuellement les essais par overlay des chromatogrammes et de constituer une base d’apprentissage robuste pour fiabiliser l’identification moléculaire. Solution livrée : Nous avons développé et déployé une plateforme IA métier spécialement pensée pour les analystes parfumeurs, intégrant un moteur d’identification basé sur Spec2Vec et NNLS, un chromatogramme interactif, une formule T/TA, un module de redosage intelligent, un overlay visuel, un système d’ajout manuel guidé, l’archivage des données et la possibilité d’ajouter prochainement de nouveaux modules IA. La plateforme, pleinement opérationnelle, est utilisée au quotidien et apporte une traçabilité intégrale ainsi qu’un gain de productivité significatif. Élimination complète d’Excel pour toutes les opérations, garantissant une traçabilité à 100 % Diminution du temps d’analyse jusqu’à 50 % pour le redosage et la comparaison des chromatogrammes grâce à l’automatisation IA Historisation de chaque ajout, sauvegarde continue des coefficients, création d’une base de données prête pour l’entraînement de modèles IA Zones de déploiement : Paris & Île-de-France, Grasse (06), Lyon et la région Auvergne-Rhône-Alpes, ainsi qu’un mode à distance pour les laboratoires installés en Europe. Témoignage client : « Nous avions besoin de sortir d’un fonctionnement artisanal basé sur AMDIS et Excel pour fiabiliser nos analyses GC-MS et accélérer nos reformulations. Koïno a rapidement compris nos enjeux métier et livré une plateforme claire, robuste et immédiatement exploitable. Le gain de temps est réel, le redosage est devenu maîtrisable, et chaque ajout est désormais traçable. C’est un outil que l’on utilise au quotidien. »

FAMA

Les équipes marketing de FAMA réalisaient de nombreux exports Excel et croisaient manuellement les données issues de Hubspot, sans jamais bénéficier d’une vision précise de leur parcours d’acquisition. En reliant toutes leurs sources à une data stack moderne, elles ont éliminé les tâches répétitives et les reportings interminables. Cette transformation a permis de prendre des décisions plus rapidement, de mieux piloter les campagnes et d’offrir à l’équipe marketing un travail plus épanouissant. Solution Hyperstack :Avant l’intégration d’Hyperstack, FAMA gérait manuellement son reporting marketing : exports de données depuis Hubspot, création de tableaux croisés sous Excel, et consolidation fastidieuse des différentes sources. Ce manque de visibilité sur leur tunnel d’acquisition ralentissait la prise de décision, démotivait les équipes et rendait le reporting particulièrement contraignant. Grâce à Hyperstack, Hubspot et l’ensemble des autres sources de données ont été connectés sur une seule plateforme. Le Head of Marketing suit désormais les KPIs mis à jour quotidiennement dans Looker Studio, les équipes travaillent directement via Google Sheets, et les rapports stratégiques s’effectuent de manière automatique. Avec la centralisation de toutes leurs données, FAMA a gagné en réactivité, réduit le temps consacré à l’analyse et repris pleinement le pilotage de son marketing. Fonctionnalités développées : Extraction des données automatisée Stockage centralisé dans un point unique Tableaux de bord mis à jour automatiquement Résultats :21 KPIs consultables en temps réel

Barnes International

Barnes International : Étude Marketing Automation Barnes International, agence immobilière de prestige, a été accompagnée dans l’étude et l’implémentation d’une solution de Marketing Automation. Ce projet a été mené en parallèle de la refonte de leur site internet et de la création de Barnes Data, leur datalake interne. L’objectif était d’optimiser la stratégie marketing de l’entreprise et de fluidifier ses processus opérationnels. Objectifs Revoir et redéfinir les personas marketing. Analyser et adapter le modèle de données Barnes Data. Recommander, sélectionner puis intégrer un outil adapté de Marketing Automation (Hubspot), et le synchroniser avec leur datalake. Optimiser et centraliser les workflows marketing pour rendre les processus plus efficaces. Défis Utilisation de multiples outils pour des actions marketing majoritairement manuelles. Difficultés de connexion entre Hubspot CRM et d’autres solutions. Assurer la cohérence des données à travers diverses plateformes. Gestion d’une base de 450 000 contacts répartis entre Brevo et des fichiers Excel. Nécessité de fusionner et redéfinir les personas afin d’assurer une segmentation optimale. Solutions apportées Mise en place d’un CRM Hubspot entièrement personnalisé. Connexion et synchronisation du CRM avec le datalake via Make. Définition et optimisation de plus de 20 workflows automatisés, représentant plus de 35 000 opérations mensuelles. Configuration d’un plan de tracking web pour affiner la mesure des performances. Unification et synchronisation des propriétés de contact et des bases de données. Rationalisation des campagnes publicitaires et des réseaux sociaux. Mise en place de sessions de formation dédiées aux équipes.

Groupe d’hôtellerie et de restauration

Objectif de la mission Les dispositifs de fidélité constituent un levier puissant pour une marque, permettant de valoriser ses clients tout en renforçant la relation client, dans le but de les fidéliser et de favoriser une augmentation de leur panier d’achats. C’est dans ce cadre que nous avons accompagné notre client, un acteur majeur du secteur hôtelier et de la restauration. Le projet visait à redynamiser un programme de fidélité parfois négligé par certaines enseignes, afin de suivre son adoption, ses performances commerciales et sa rentabilité, et d’exploiter pleinement la base clients. L’ambition ultime pour notre client est de consolider la fidélité de sa clientèle existante, tout en séduisant de nouveaux clients à travers un programme de fidélité attractif et performant. Contexte de la mission Le groupe réunit une centaine d’établissements. Le programme de fidélité est proposé lors des réservations, mais il n’est pas systématiquement mis en avant par tous les points de vente. Par ailleurs, aucun dispositif fiable ne permettait auparavant au groupe de suivre l’adoption du programme et d’en évaluer précisément les performances. Les données du programme de fidélité sont transmises chaque jour, sous format CSV, par un prestataire chargé des systèmes de paiement. Pour répondre à ces enjeux, la mise en place d’une infrastructure data sur AWS a été préconisée, afin de centraliser et d’exploiter les données collectées, tout en assurant la fiabilité et le suivi des indicateurs de performance. Résultats de la mission Suite à notre intervention, notre client bénéficie de tableaux de bord détaillés pour suivre l’évolution de son programme de fidélité, au niveau de chaque établissement mais aussi à l’échelle du groupe. Cela permet un pilotage plus affiné et l’optimisation du dispositif en fonction des résultats mesurés. Nous avons aussi mis en œuvre une segmentation fine de la base clients, relançant ainsi les clients inactifs et contribuant à l’amélioration de la satisfaction globale (par exemple via des offres personnalisées après une réservation). De plus, une Data Platform complète a été développée sur AWS, intégrant systèmes de monitoring et d’alerting, garantissant ainsi la fiabilité et l’efficacité de l’ensemble du programme. Solution implémentée Pour mener à bien ce projet, nous avons opté pour une stack data sur AWS, parfaitement compatible avec l’environnement technique de notre client. La première phase a porté sur la collecte des données, avec la mise en place d’un processus fiable d’ingestion et d’historisation, essentiel pour ne perdre aucune information clé. La seconde étape a relevé le défi de la qualité des données. Chaque lot de données transmis pouvait présenter des formats différents et comporter des erreurs. Pour y remédier, des systèmes d’alerting et de tests ont été déployés, assurant la robustesse des flux de données. Troisièmement, nous avons identifié les KPIs pertinents et développé les transformations nécessaires pour alimenter les différents tableaux de bord d’analyse. La quatrième phase s’est concentrée sur l’analyse des comportements d’achat et la segmentation de la clientèle (par exemple, clients réguliers, clients inactifs, etc.), permettant ainsi de lancer des campagnes marketing ciblées vers des segments spécifiques. Enfin, nous avons conçu des tableaux de bord sur-mesure pour différents profils utilisateurs chez notre client : Pour la direction, afin de disposer d’une vision globale des performances du programme de fidélité Pour les responsables de comptes, afin de suivre, pour chaque établissement dont ils ont la charge, les indicateurs clés Pour les équipes marketing, leur permettant d’identifier des leviers d’optimisation et de piloter des actions ciblées (relance de clients, propositions de promotions personnalisées, etc.) La Stack mise en place Cloud provider : AWS Data Storage : RDBS, S3, Athena Data transformation : Python, SQL, AWS lambda Data Orchestration : SNS, Cloud Scheduler

SVR

Grâce à une automatisation complète du traitement de ses commandes en ligne, SVR dispose désormais d’un flux de données robuste et conforme. Cette solution invisible mais essentielle permet de transformer des ventes complexes (bundles, remises, devises) en fichiers prêts à l’intégration dans Sage X3.Résultat : des données plus fiables, un chiffre d’affaires consolidé automatiquement et un pilotage simplifié de l’activité e-commerce.Solution HyperstackContexteDepuis janvier 2025, une des marques de SVR a enregistré plus de 45 000 commandes sur sa boutique Shopify. Ces données devaient être intégrées dans Sage X3. Mais il n’existait pas de connecteur direct et le volume était trop important pour un traitement manuel.Les difficultés :Bundles à éclater et valoriser article par articleRemises à répartir correctement sur chaque produitGestion des devises et des codes clients Sage X3Besoin de consolider le chiffre d’affaires mensuelSolution ApportéeHyperstack est intervenu en deux étapes.D’abord, un retraitement ponctuel a permis de produire un fichier .csv conforme à Sage X3 : décomposition des bundles, valorisation des articles, prise en compte des remises et des devises. Les ventes ont pu être intégrées rapidement dans l’ERP.Ensuite, le processus a été automatisé :Extraction quotidienne des ventes Shopify, TikTok Shop et Amazon via AirbyteTransformation et regroupement des données avec DBT et BigQueryGénération automatique des fichiers clients et dépôt sur FTP avec n8nLes résultats sont clairs :Plus de retraitements manuelsDonnées fiables et prêtes à l’intégrationChiffre d’affaires consolidé automatiquement chaque moisSolution évolutive pour intégrer de nouveaux canaux de venteAujourd’hui, SVR dispose d’un flux de données automatisé et fiable. L’entreprise gagne du temps, réduit les erreurs et pilote son e-commerce plus efficacement.

Cabinet d’architecture renommé (non nommé)

Pour une gestion client plus simple et automatisée Digitallia, spécialiste des solutions personnalisées en intelligence artificielle, a accompagné un cabinet d’architecture de renom établi en Auvergne Rhône Alpes, reconnu pour ses projets résidentiels et commerciaux haut de gamme. Ce cabinet souhaitait optimiser la phase de conception afin d’accélérer la production tout en offrant des designs innovants et parfaitement adaptés aux attentes de sa clientèle. Défis rencontrés : La phase de conception prenait du temps et exigeait de nombreuses itérations. L’introduction d’innovations rapides présentait une difficulté, sans pour autant augmenter la charge de travail des architectes. La personnalisation était complexe en raison de la variété des exigences clients et des contraintes réglementaires à prendre en compte. Objectif : Utiliser l’intelligence artificielle générative afin de générer rapidement des concepts de projets intégrant critères esthétiques, durabilité et exigences techniques. Solutions mises en place : Mise en œuvre d’un modèle 3D génératif pour réaliser très rapidement des concepts architecturaux (plans, façades, perspectives intérieures). Possibilité pour les architectes de paramétrer divers éléments : surface, style, choix des matériaux, contraintes budgétaires, pour une personnalisation optimale des résultats générés. Simulations et analyses automatisées dédiées à l’évaluation de la consommation d’énergie et des coûts. Déploiement d’une interface collaborative permettant aux architectes de modifier, ajuster et sélectionner les concepts générés selon des critères tels que les textures, les volumes ou l’aménagement. Résultats obtenus : Temps de création des concepts réduit de 40 %. Satisfaction client renforcée, grâce à la présentation de plusieurs alternatives personnalisées dès la phase initiale. Estimation budgétaire précise, facilitant la phase d’avant-vente. Une amélioration de la première version du POC reste envisageable pour certains types de biens. L’enrichissement de la base de données et une seconde version enrichie, intégrant davantage de fonctionnalités métier, sont prévus pour 2025. Conclusion La solution d’IA générative conçue par Digitallia permet au cabinet d’architecture de gagner en efficacité pendant la phase de production avant-vente, tout en apportant une valeur ajoutée à sa propre clientèle et en respectant les exigences de son secteur.

Agoterra

Grâce à une transformation technique en profondeur, Agoterra bénéficie désormais d’un back-end solide, automatisé et évolutif. Cette infrastructure, invisible mais vitale, permet de valoriser chaque projet agroécologique en garantissant des données plus fiables, plus lisibles et plus faciles à exploiter. ContexteLa plateforme Bubble d’Agoterra joue un rôle clé en connectant les investisseurs et les exploitations agricoles. Cependant, face à l’augmentation de l’activité, le système atteignait ses limites : Infrastructure insuffisamment scalable Prolifération des intégrations semi-manuelles Granularité limitée des données projets (absence de vue détaillée par culture ou exploitation) Difficultés de fiabilisation et de maintenance Ces contraintes ralentissaient l’équipe, nuisaient à la qualité du reporting et limitaient l’amélioration de l’expérience pour les investisseurs. Solution apportéeAgoterra a fait appel à Hyperstack afin de lever ces obstacles techniques. Après un audit approfondi, nous avons recommandé une refonte complète de l’architecture back-end, misant sur une stack moderne, centralisée et évolutive. Architecture centralisée sur Xano, connectée à l’interface WeWeb Automatisation des flux de données via DBT et BigQuery, facilitant l’intégration des données partenaires sans intervention manuelle Socle technique fiable, structuré et évolutif pour accompagner la croissance future En conclusion, sans modifier l’interface, Agoterra bénéficie désormais d’une plus grande clarté, d’une fiabilité renforcée et, surtout, d’une excellente capacité d’évolution.

La data visualization, ou visualisation de données, revêt aujourd'hui une importance cruciale dans le monde du data marketing et de l’analytics. Elle consiste à transformer des données brutes en représentations visuelles claires et engageantes, ce qui non seulement facilite la compréhension pour les clients, mais améliore également la prise de décision au sein des entreprises.

La data visualization se définit comme l’art de représenter des informations complexes sous forme de graphiques, tableaux de bord ou rapports visuels. Par exemple, l'utilisation de Google Data Studio ou de Microsoft Fabric permet de créer des tableaux de bord personnalisés illustrant clairement les performances marketing. Ces outils offrent des KPI facilement compréhensibles, rendant les décisions éclairées plus accessibles pour les entreprises. Cela est d'autant plus nécessaire que la capacité à interpréter et exploiter efficacement les données confère aux entreprises un avantage concurrentiel considérable dans l'ère du big data.

Le recours à la data visualization présente de nombreux avantages indéniables. Il permet une interprétation rapide et efficace de sources de données complexes, condition préalable à des stratégies data-driven marketing. En facilitant la visualisation business intelligence, les entreprises peuvent anticiper les tendances, optimiser leurs processus et améliorer la satisfaction clients. Des outils comme Google Analytics et Zoho Analytics illustrent parfaitement comment une analyse visuelle peut transformer des données brutes en insights précieux.

Le choix d'une agence spécialisée en data visualization en France est crucial pour optimiser les résultats de vos projets de visualisation de données. Plusieurs critères doivent être pris en compte pour choisir une agence de data marketing compétente.

Une agence de data visualization doit démontrer une expertise technique solide. L'innovation est primordiale pour intégrer des technologies de pointe comme le machine learning ou l’intelligence artificielle dans leurs solutions. La capacité à rester à la pointe de la technologie assure que vos projets bénéficient des dernières avancées, maximisant ainsi leur impact.

Analyser le portfolio d'une agence vous donne un aperçu de ses réalisations précédentes. Examiner des cas clients et des témoignages aide à évaluer leur capacité à manager des projets complexes et à proposer des solutions sur mesure. Des collaborations avec des entreprises renommées comme EDF ou des projets à Paris et Lyon sont révélateurs de leur qualité et compétence.

La capacité d'une agence à s'adapter aux besoins spécifiques des clients est essentielle. Leur approche devrait être centrée sur le client, avec une compréhension approfondie de leurs attentes, assurant chaque tableau de bord ou rapport répond précisément aux besoins établis.

L’évolution de la data visualization s’accompagne de l’émergence de nouvelles technologies et approches.

L'adoption de technologies émergentes comme Snowflake ou les Customer Data Platforms (CDP) modifie la manière dont les données sont visualisées. L'intégration de ces outils permet des analyses plus rapides, enrichissant ainsi la visualisation des données.

L'évolution vers des solutions centrées sur l'utilisateur met l'accent sur l'expérience utilisateur et sa facilité d'utilisation. Les projets actuels de visualisation de données visent à favoriser des interactions intuitives, stimulant l'engagement et l'efficacité.

Pour garantir le succès de vos projets de data visualization, évaluer la performance de l'agence est fondamental.

Le suivi de projet est déterminant pour mesurer l’impact de la visualisation sur votre entreprise. Utiliser des outils de business intelligence pour analyser les résultats et ajuster vos stratégies est indispensable pour une réussite continue et pérenne.

Les avis et témoignages clients fournissent des insights sur la qualité du service et peuvent guider votre décision vers le choix d'une agence de confiance.

Choisir la bonne agence de data visualization est crucial pour tirer pleinement parti de vos données. En vous concentrant sur l'expertise, l'innovation, la satisfaction client, et en vous appuyant sur des témoignages et un portfolio solide, vous pouvez vous assurer d’un investissement bénéfique apportant des avantages durables et un avantage compétitif à votre entreprise.

Avec un marché mondial de la visualisation de données évalué à 5,7 milliards de dollars en 2022 et prévu de croître annuellement de 10,2 % jusqu'en 2030, l'importance stratégique de la data visualization dans le paysage moderne ne peut être sous-estimée. Dans ce contexte, collaborer avec une agence compétente peut être déterminant pour naviguer dans le monde complexe du big data et des analytics avec confiance et succès.

Vous cherchez un partenaire technique mais ne savez pas par où commencer ? Voici les réponses aux questions les plus courantes.

En France, on compte près de 300 agences spécialisées en Data Visualisation, concentrées en Île-de-France (près de 40 % du marché), mais aussi dans les métropoles comme Lyon, Nantes et Lille, qui bénéficient de pôles numériques structurés. L’Île-de-France s’appuie sur la présence de grands groupes et d’un tissu dense de start-ups, tandis que la région Auvergne-Rhône-Alpes profite de l’écosystème industriel et du cluster Digital League. Les régions Nouvelle-Aquitaine et Occitanie, grâce à la dynamique de Toulouse et Bordeaux, tirent aussi leur épingle du jeu — on y trouve plus de 6000 professionnels du numérique, dont une proportion en hausse dans la Data Science et la visualisation de données. Ce maillage hétérogène offre un choix adapté au tissu économique local, des PME industrielles du Grand Est aux acteurs de la smart-city du Sud, traitant des cas d’usage variés comme le pilotage industriel, l'analyse marketing ou la gouvernance de la donnée publique.

Les coûts varient selon la complexité du projet et l’expertise de l’agence. À l’échelle nationale, le développement d’un dashboard sur-mesure démarre autour de 7 000 € pour un projet simple, et peut grimper à 50 000 € ou plus pour des besoins avancés intégrant de la BI, du temps réel et des volumes massifs de données. En Île-de-France, là où le coût du travail est plus élevé (salaire moyen d’un Data Analyst autour de 48 000 €/an), les tarifs sont généralement 10 à 20 % supérieurs à ceux constatés en régions. Les projets typiques des ETI régionales se situent dans une fourchette de 15 000 à 25 000 €, incluant conception, développement, et accompagnement à la prise en main. Les délais de réalisation s’étalent le plus souvent de 6 à 12 semaines, en lien avec la disponibilité des ressources et la complexité des data flows.

Les agences recherchent une diversité de profils : Data Analysts, Data Scientists, Développeurs BI, UX/UI Designers, et consultants métier. Le secteur emploie environ 10 000 professionnels dans la Data Visualisation au niveau national, soit 12 % de la filière data (source Pôle Emploi). Les régions comme Auvergne-Rhône-Alpes et Nouvelle-Aquitaine se distinguent par la présence d’écoles d’ingénieurs spécialisées (INSA, ENSEEIHT, Epitech) et une forte collaboration avec des pôles de compétitivité (Minalogic, Aerospace Valley). La pénurie de profils seniors, surtout hors grandes métropoles, encourage les agences à investir dans l’alternance et la formation continue, tandis que le télétravail permet de capter des compétences rares dans les bassins ruraux.

En France, Tableau, Power BI et Qlik Sense sont leaders sur le terrain de la Data Visualisation, respectivement adoptées par 32 %, 41 % et 12 % des entreprises utilisatrices. Cela s’explique par leur compatibilité avec les architectures SI des grands groupes, le soutien actif des éditeurs et la présence de communautés locales très structurées, notamment à Paris (meetups réguliers) et dans les métropoles comme Nantes ou Toulouse. À cela s’ajoutent des solutions open source telles que Kibana ou D3.js, prisées dans les écosystèmes startup pour leur souplesse et coût maîtrisé. Les secteurs industriels (automobile, aéronautique) privilégient souvent des outils robustes comme Qlik ou Power BI, alors que les acteurs du retail et du e-commerce misent sur des visualisations web interactives développées sur mesure.

Le panel de clients est large : grands groupes (banques, énergie), ETI industrielles, collectivités territoriales, mais aussi startups de la « French Tech ». Près de 56 % des missions recensées concernent l’aide à la décision pour PME et ETI entre 50 et 500 salariés. Les collectivités locales, notamment dans les régions Pays de la Loire et Occitanie, commandent des tableaux de bord pour piloter politiques publiques et open data. L’industrie et le secteur santé, surtout dans les bassins de Lyon, Lille ou Aix-Marseille, sollicitent les agences pour des visualisations avancées d’indicateurs qualité ou de suivi logistique. Les startups de la French Tech, dont Paris concentre plus de 30 %, recherchent des interfaces très UX et des visualisations temps réel pour leurs plateformes SaaS.

La Data Visualisation profite du développement rapide du secteur de la data, qui enregistre une croissance annuelle de plus de 7 % sur les trois dernières années. Selon l’INSEE, plus de 85 000 emplois directs sont recensés dans la filière data/IA en 2023 en France, dont environ 12 000 concernent directement la visualisation et les interfaces BI. L’Île-de-France concentre 38 % de ces effectifs, tandis qu’Auvergne-Rhône-Alpes, Occitanie et les Hauts-de-France s’affirment comme nouveaux pôles compétitifs. Les salaires débutent à 36 000 € brut/an pour un Data Visualisation Developer junior, et dépassent 50 000 € pour des profils seniors ou spécialisés sur des technologies rares. La montée en puissance de clusters régionaux, comme Cap Digital (Paris), Eurobiomed (Sud-Est), accélère encore l’attractivité du secteur en région.

Un projet type débute par un cadrage (1 à 2 semaines), où l’agence analyse les sources de données, les besoins métier et les usages cibles. Vient la phase de prototypage, généralement sous forme de maquettes interactives sous Power BI ou Tableau, sur 2 à 3 semaines. S’ensuit l’intégration technique et le développement des dashboards, sur 3 à 6 semaines, en lien avec le département IT client. Enfin, la formation des utilisateurs et l’accompagnement au changement prennent 1 à 2 semaines supplémentaires, portés souvent par des consultants certifiés. Le process inclut toujours un volet conformité RGPD — cruciale pour les entreprises basées en Île-de-France ou dans la santé (normes HDS). En moyenne, un tel projet s’étale sur 8 à 12 semaines. Plus de 60 % des agences proposent aussi des offres de maintenance ou d’évolution post-mise en production.

La montée en puissance du cloud (Azure, AWS, Google Cloud) transforme durablement la Data Visualisation : 65 % des entreprises françaises prévoient de déplacer tout ou partie de leur analytic sur le cloud d’ici 2025. L’essor de l’open data et de la dataviz citoyenne, porté par des initiatives publiques (2000 portails open data locaux ouverts depuis 5 ans), impacte aussi la demande. On note une forte adoption des technologies de visualisation en temps réel, notamment dans la mobilité urbaine (Paris, Lyon, Bordeaux), l’industrie (IoT) et la cybersécurité. Les formations Data Viz, via écoles d’ingénieurs (Mines, Centrale) ou écoles spécialisées en design numérique, ont vu leurs effectifs croître de 15 % en deux ans, signe d’une structuration de la filière. L’automatisation, l’IA générative et la personnalisation des visualisations seront les leviers d’innovation majeurs à horizon 2026.