Eleven Labs

Des experts augmentés par l'intelligence collective.

Des experts augmentés par l'intelligence collective.

Découvrez les cabinets de conseil Data à Paris grâce à notre classement 2025, spécialement conçu pour vous guider vers les experts les plus compétents de la capitale. La transformation numérique et la maîtrise des données sont aujourd’hui au cœur de la performance des entreprises, et choisir un partenaire à la hauteur de ces enjeux est essentiel. Les agences sélectionnées allient expertise avancée en gestion et valorisation des Data à une connaissance fine de l’écosystème parisien, garantissant un accompagnement pertinent et adapté à votre contexte local. Fiez-vous à la sélection rigoureuse de La Fabrique du Net pour comparer les talents et trouver le cabinet de conseil Data qui saura répondre à vos attentes et ambitions. Parcourez notre liste et découvrez les meilleurs spécialistes parisiens.

Des experts augmentés par l'intelligence collective.

Des experts augmentés par l'intelligence collective.

Hyperstack accompagne les entreprises à devenir plus performantes et data-driven grâce au no-code, à la data et à l’IA.

Hyperstack accompagne les entreprises à devenir plus performantes et data-driven grâce au no-code, à la data et à l’IA.

Benjamin P.

Ben&Vic

09/2025

Formation / Coaching / RH

One Learn forme des professionnels autour de l’architecture et du design, avec une activité en forte croissance.Pour mie...

Économie sociale / ONG / ESS

Grâce à une transformation technique en profondeur, Agoterra bénéficie désormais d’un back-end solide, automatisé et évo...

Retail / E-commerce / Consommation

Grâce à une automatisation complète du traitement de ses commandes en ligne, SVR dispose désormais d’un flux de données...

Culture / Médias / Divertissement

Comment Values Media a divisé par 3 son temps de reporting ? Autrefois, chaque nouveau client impliquait de longues heur...

Vous avez du mal à choisir votre agence ? Laissez-nous vous aider gratuitement

CRM, IT, DATA, IA

CRM, IT, DATA, IA

.jpeg)

Thibaut P.

Gérant • Numenys

12/2025

Partenaire de votre transformation Data & IA

Partenaire de votre transformation Data & IA

Ismail M.

Lead Data Engineering - Data Platform Team • Accor

01/2026

Manuel D.

CTO • Madkudu

01/2026

Adrien P.

CTO • Citron

01/2026

We are Eurelis, Smart Applications Maker !

We are Eurelis, Smart Applications Maker !

Banque / Assurance / Fintech

Eurelis accompagne Société Générale, grande banque européenne de premier plan, dans la conception, le développement et l...

Industrie / Énergie / Ingénierie

Eurelis accompagne Mastrad, marque française reconnue d’ustensiles de cuisine innovants, dans la conception, le développ...

Virtuous Innovators

Virtuous Innovators

Services publics / Éducation

Problème Automatisation des données : informations dispersées L'absence d'automatisation empêche d’obtenir de la visibil...

Industrie / Énergie / Ingénierie / Mode / Luxe / Beauté

Mission : Un acteur du secteur de la parfumerie souhaitait dépasser les limites des solutions AMDIS et Excel pour analys...

🚀 Solutions Digitales Sur-Mesure pour les PME et ETI

🚀 Solutions Digitales Sur-Mesure pour les PME et ETI

Capt IA Optimisez l’humain, automatisez l’essentiel

Capt IA Optimisez l’humain, automatisez l’essentiel

On aide les PME à tirer parti de l’IA

On aide les PME à tirer parti de l’IA

DreamOnTech vous propulse au-delà de l'imagination !

DreamOnTech vous propulse au-delà de l'imagination !

-thumb.jpg)

SLAP digital est une agence FR spécialisée sur les problématiques d'acquisition (SEA/SEO/GEO/SMA/Analytics) et d'écosystème digital (Sites, PIM, DAM).

SLAP digital est une agence FR spécialisée sur les problématiques d'acquisition (SEA/SEO/GEO/SMA/Analytics) et d'écosystème digital (Sites, PIM, DAM).

Agence intelligence artificielle, machine learning et data. Experts du développement d'IA sur mesure, ou à partir d'un modèle existant.

Agence intelligence artificielle, machine learning et data. Experts du développement d'IA sur mesure, ou à partir d'un modèle existant.

Rapprochez-vous du lancement de votre prochain projet dès aujourd'hui

Notre méthodologie repose sur des critères objectifs et vérifiables pour garantir la pertinence de nos recommandations.

Voir la méthodologie détailléeClassement impartial basé sur la data. Aucune agence ne paie pour sa note.

Identité légale, santé financière et expertises sont auditées par notre équipe.

Nous modérons les avis pour filtrer les faux témoignages et garantir l'authenticité.

Découvrez les dernières réalisations des meilleures agences à Paris

IESEG

Problème Automatisation des données : informations dispersées L'absence d'automatisation empêche d’obtenir de la visibilité, multiplie les doublons et ralentit le traitement métier. Les équipes réalisent une consolidation manuelle de sources variées, ce qui dégrade la qualité des données et complique la prise de décision. Solution Pipeline IA pour automatiser la gestion des données Le projet implémente une infrastructure unifiée permettant de fiabiliser et enrichir la base alumni. Airbyte gère l’extraction des flux, BigQuery assure le stockage et dbt structure les jeux de données. GPT-4 catégorise les changements, Sentence-BERT élimine les doublons. Les APIs LinkedIn / Sales Navigator fournissent l’enrichissement en temps réel, et n8n automatise les mises à jour. Résultats Réduction des doublons Le taux de doublons est passé de 18 % à 0,8 %, validant l’efficacité du modèle d’embedding. Amélioration de la productivité La durée moyenne des mises à jour est passée de 20 minutes à 45 secondes via les webhooks LLM, économisant 36 heures par mois. Hausse de la fiabilité des profils La proportion de profils à jour a augmenté de 62 % à 95 %, selon un audit interne. Contexte IESEG administre une communauté de plus de 20 000 anciens élèves dont les carrières sont en constante évolution. Les services internes gèrent des sources multiples souvent en doublon, ce qui complique la consolidation des profils. L’automatisation vise à créer un référentiel partagé, fiable, accessible quasiment en temps réel. Problématique Données réparties dans plusieurs bases, absence de vision consolidée Multiplication des doublons et champs obsolètes Mises à jour lentes, réalisées manuellement Incapacité à détecter automatiquement les évolutions de poste Décisions retardées pour les équipes alumni et carrières Difficulté à mesurer l'impact et le retour sur investissement des actions réseaux Solution technique Stack intégrée : Airbyte pour l’extraction, BigQuery comme entrepôt, dbt pour le modeling, le tout sur Google Cloud. Collecte LinkedIn : utilisation d’un crawler maison et de l’API Sales Navigator ; classification en temps réel des changements de poste avec GPT-4 ; automatisation de la mise à jour via webhooks n8n (moins de 15 minutes). Nettoyage et déduplication : fusion automatique des doublons grâce à Sentence-BERT. Workflows IA : enrichissement sémantique via Vertex AI, contrôle qualité par Great Expectations, intégration PostgreSQL + Hasura GraphQL, dashboard Retool, alertes via Slack. Indicateurs clés Métrique cléAvantAprès Taux de doublons18 %< 1 % Profils à jour62 %95 % Temps de mise à jour20 min< 1 min Charge mensuelle de maintenance40 h homme4 h homme Délai de diffusion signaux carrière2 semaines15 min Fiabilité des données63 %95 % ROI projet (économies/an)—× 4,2 La modernisation a permis de réduire considérablement les doublons, accélérer les mises à jour quasi instantanées et libérer une semaine-homme mensuelle pour les équipes carrières. Désormais, la base unifiée garantit une fiabilité de 95 % des données, ce qui favorise la personnalisation des programmes alumni et la prospection. La surveillance automatisée des changements alimente un système d’alertes utilisé par trois services internes. IESEG dispose ainsi d’un référentiel robuste, conforme au RGPD et prêt à être étendu à d’autres populations étudiantes. Pipeline data versionné pour auditer chaque transformation. Règles qualité automatiques en continu. Déclenchement automatique des mises à jour à chaque détection de changement. Mise à jour semestrielle des embeddings pour optimiser la déduplication. Prochains développements prévus : validation blocking, extension des intégrations LinkedIn, scoring prédictif, audit RGPD, et gouvernance multi-entités.

CP

Département concerné : 💸 Finance & administratif Situation initiale : ⚠️ Un suivi commercial et financier réalisé manuellement Résultats clés : ✅ Mise en place et intégration de Pennylane et Hubspot, création de tableaux de bord KPIs consultables en temps réel, notifications automatiques envoyées via Slack, élaboration de nouveaux processus et documentation opérationnelle. 📊 Optimisation du temps de travail et amélioration de la communication entre les équipes commerciale, comptable et opérationnelle. Possibilité de suivre l'activité instantanément.

Parfumsplus

Mission : Un acteur du secteur de la parfumerie souhaitait dépasser les limites des solutions AMDIS et Excel pour analyser ses données GC-MS et accélérer la reformulation de ses fragrances. Pour répondre à ce besoin, nous avons conçu une plateforme d’intelligence artificielle spécialement dédiée à la parfumerie. Celle-ci centralise les bibliothèques de molécules et matières naturelles, génère une formule globale polaire/apolaire, permet la superposition des chromatogrammes de marché et d’essai, et offre un module de redosage incluant des coefficients de réponse. Grâce à cette approche unifiée, analyse et reformulation sont désormais réunies au sein d’un même outil, sans utilisation de tableurs, avec une traçabilité totale et des données prêtes à alimenter des modèles d’IA. Ce projet démontre concrètement l’apport de l’IA appliquée au GC-MS dans l’évolution de la formulation de parfums et l’optimisation du travail des analystes. Problématique : Chez Parfumsplus, les équipes d’analyse travaillaient avec une succession d’outils non connectés — principalement AMDIS pour l’analyse GC-MS, et Excel pour la formulation et le redosage. Ce fonctionnement engendrait une perte de temps due aux ajustements manuels, un déficit de traçabilité des choix réalisés, ainsi qu’une impossibilité de standardiser les étapes de reformulation. Chaque analyste appliquait alors ses propres méthodes, avec un risque élevé d’erreurs ou d’incohérences. Objectifs : Le client visait à remplacer cette organisation morcelée par une plateforme unifiée capable de centraliser toutes les librairies de molécules et matières naturelles, de générer automatiquement une formule globale T/TA, d’intégrer un module de redosage basé sur des marqueurs et des coefficients de réponse, de comparer visuellement les essais par overlay des chromatogrammes et de constituer une base d’apprentissage robuste pour fiabiliser l’identification moléculaire. Solution livrée : Nous avons développé et déployé une plateforme IA métier spécialement pensée pour les analystes parfumeurs, intégrant un moteur d’identification basé sur Spec2Vec et NNLS, un chromatogramme interactif, une formule T/TA, un module de redosage intelligent, un overlay visuel, un système d’ajout manuel guidé, l’archivage des données et la possibilité d’ajouter prochainement de nouveaux modules IA. La plateforme, pleinement opérationnelle, est utilisée au quotidien et apporte une traçabilité intégrale ainsi qu’un gain de productivité significatif. Élimination complète d’Excel pour toutes les opérations, garantissant une traçabilité à 100 % Diminution du temps d’analyse jusqu’à 50 % pour le redosage et la comparaison des chromatogrammes grâce à l’automatisation IA Historisation de chaque ajout, sauvegarde continue des coefficients, création d’une base de données prête pour l’entraînement de modèles IA Zones de déploiement : Paris & Île-de-France, Grasse (06), Lyon et la région Auvergne-Rhône-Alpes, ainsi qu’un mode à distance pour les laboratoires installés en Europe. Témoignage client : « Nous avions besoin de sortir d’un fonctionnement artisanal basé sur AMDIS et Excel pour fiabiliser nos analyses GC-MS et accélérer nos reformulations. Koïno a rapidement compris nos enjeux métier et livré une plateforme claire, robuste et immédiatement exploitable. Le gain de temps est réel, le redosage est devenu maîtrisable, et chaque ajout est désormais traçable. C’est un outil que l’on utilise au quotidien. »

SVR

Grâce à une automatisation complète du traitement de ses commandes en ligne, SVR dispose désormais d’un flux de données robuste et conforme. Cette solution invisible mais essentielle permet de transformer des ventes complexes (bundles, remises, devises) en fichiers prêts à l’intégration dans Sage X3.Résultat : des données plus fiables, un chiffre d’affaires consolidé automatiquement et un pilotage simplifié de l’activité e-commerce.Solution HyperstackContexteDepuis janvier 2025, une des marques de SVR a enregistré plus de 45 000 commandes sur sa boutique Shopify. Ces données devaient être intégrées dans Sage X3. Mais il n’existait pas de connecteur direct et le volume était trop important pour un traitement manuel.Les difficultés :Bundles à éclater et valoriser article par articleRemises à répartir correctement sur chaque produitGestion des devises et des codes clients Sage X3Besoin de consolider le chiffre d’affaires mensuelSolution ApportéeHyperstack est intervenu en deux étapes.D’abord, un retraitement ponctuel a permis de produire un fichier .csv conforme à Sage X3 : décomposition des bundles, valorisation des articles, prise en compte des remises et des devises. Les ventes ont pu être intégrées rapidement dans l’ERP.Ensuite, le processus a été automatisé :Extraction quotidienne des ventes Shopify, TikTok Shop et Amazon via AirbyteTransformation et regroupement des données avec DBT et BigQueryGénération automatique des fichiers clients et dépôt sur FTP avec n8nLes résultats sont clairs :Plus de retraitements manuelsDonnées fiables et prêtes à l’intégrationChiffre d’affaires consolidé automatiquement chaque moisSolution évolutive pour intégrer de nouveaux canaux de venteAujourd’hui, SVR dispose d’un flux de données automatisé et fiable. L’entreprise gagne du temps, réduit les erreurs et pilote son e-commerce plus efficacement.

One Learn

One Learn forme des professionnels autour de l’architecture et du design, avec une activité en forte croissance.Pour mieux piloter leurs performances commerciales, leurs investissements marketing et les coûts d’acquisition, One Learn souhaitait remplacer des analyses éclatées par un reporting unifié, fiable et automatisé.Grâce à la mise en place d’une architecture data moderne, l’entreprise bénéficie désormais d’une vision consolidée de l’ensemble de son funnel : CRM, dépenses SEA et performance SEO.Solution HyperstackContexteOne Learn s’appuyait principalement sur Pipedrive pour gérer ses leads et ses opportunités.Le CRM constituait la source centrale, mais plusieurs limites freinaient l’analyse :Des données dispersées entre Pipedrive, Google Ads et Google Search ConsoleAucune vision consolidée du funnel d’acquisitionDifficulté à sectoriser les différents types de deals (organique, SEO, emailing…)Impossible de calculer précisément les coûts d’acquisition (CPA)Reporting manuel, chronophage, dépendant d’extractions ponctuellesLes équipes marketing et sales manquaient ainsi d’un dashboard global permettant de suivre les performances, les coûts, les revenus et le ROI de manière unifiée.Solution apportéeHyperstack a construit une Modern Data Stack complète permettant de centraliser, transformer et visualiser l’ensemble des données commerciales et marketing de One Learn.Extraction automatisée des donnéesToutes les sources ont été connectées via Fivetran :Pipedrive (données CRM et pipelines)Google Ads (dépenses SEA)Google Search Console (performance SEO)Centralisation dans BigQueryLes données issues des trois sources sont entreposées dans un data warehouse unique et fiable.Transformation et harmonisationLes pipelines de transformation unifient les tables CRM, SEA et SEO afin de :sectoriser les deals selon leur origine (organique, SEO, emailings, pipelines internes),calculer les leads, deals gagnés, chiffre d’affaires,intégrer les coûts et déterminer le coût par lead,fournir les métriques nécessaires au calcul du ROI.Dashboard unifié sur Data StudioToutes les données sont visualisées dans un tableau de bord unique consolidant :CRM (Pipedrive)SEA (Google Ads)SEO (Search Console)One Learn dispose désormais d’une plateforme d’analyse robuste permettant une prise de décision éclairée sur l’ensemble de son acquisition.RésultatsVision centralisée des performances CRM, SEA et SEOSectorisation claire des types de deals (organique, SEO, email, formations)Calcul complet des coûts, notamment le coût par leadUn ROI unifié, intégrant revenus, dépenses et performance SEOFin des extractions manuelles, grâce à une automatisation totale du flux (Fivetran → BigQuery → Dashboard)Un socle évolutif pour de futurs cas d’usage : attribution avancée, scoring, prédiction des conversions

Mastrad

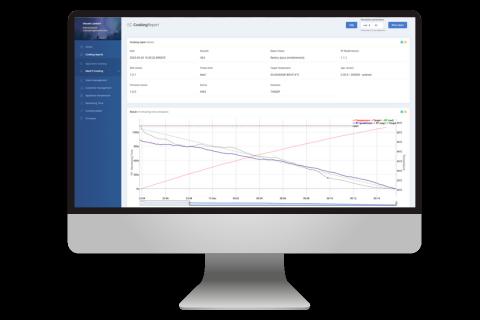

Eurelis accompagne Mastrad, marque française reconnue d’ustensiles de cuisine innovants, dans la conception, le développement et l’industrialisation d’une application intelligente intégrant un algorithme prédictif de cuisson pour optimiser l’expérience utilisateur et renforcer la valeur ajoutée des produits connectés.Mastrad est une société française spécialisée dans les instruments de cuisine innovants, et notamment dans les solutions de contrôle de la température de cuisson destinées aux professionnels et aux particuliers.Contexte du projetDans le cadre du développement de nouvelles fonctionnalités pour ses produits connectés, Mastrad a confié à Eurelis la conception d’un algorithme prédictif de cuisson, capable d’estimer le temps restant de cuisson en fonction de différents paramètres (type d’aliment, méthode de cuisson, préférences utilisateur).Objectifs du projetConcevoir un modèle de Machine Learning fiable pour prédire les temps de cuisson restants.Intégrer cette intelligence dans une application métier robuste, scalable et adaptée aux contextes variés de cuisson.Déployer une infrastructure cloud capable de gérer l’entraînement, la supervision et la distribution du modèle.Optimiser les coûts et assurer la scalabilité grâce à des composants serverless.Défis techniques et organisationnelsExploiter des données hétérogènes issues de sondes culinaires pour constituer un modèle prédictif fiable.Concevoir une solution capable de s’adapter à une grande variété de cas de cuisson (viande, poisson, différentes méthodes et dispositifs).Mettre en place une architecture cloud scalable et résiliente, tout en garantissant simplicité d’intégration pour les applications clientes.Approche de co-création :Eurelis a travaillé en étroite collaboration avec les équipes Mastrad pour :Analyser et structurer les données remontées par les sondes culinaires.Concevoir un modèle de Machine Learning basé sur TensorFlow, entraîné puis supervisé via une infrastructure Cloud.Développer l’intégration backend pour permettre l’entraînement à la demande et la supervision de la qualité des prédictions.Solution technique et expertises mobiliséesLa plateforme s’appuie sur une combinaison d’expertises techniques modernes :Machine Learning & Algorithmie prédictive avec TensorFlow (Python).Infrastructure Cloud AWS pour orchestrer l’entraînement, la supervision et la distribution du modèle.Architecture backend scalable, exploitant des composants serverless pour optimiser la performance et les coûts.Application métier permettant la supervision et l’exploitation du système de prédiction.Résultats et bénéficesMise en place d’un modèle prédictif fiable, capable d’estimer avec précision les temps restants de cuisson dans des contextes variés.Infrastructure backend scalable permettant l’évolution continue des modèles et l’intégration dans les applications clientes.Optimisation des coûts via une architecture serverless adaptée aux variations de charge.Autonomie de Mastrad dans la supervision, l’entraînement et l’amélioration du modèle de prédiction.

Société générale

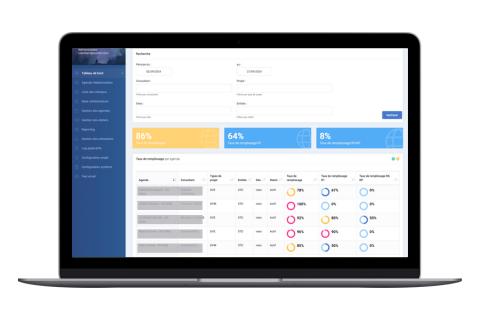

Eurelis accompagne Société Générale, grande banque européenne de premier plan, dans la conception, le développement et le déploiement d’une application métier intelligente d’optimisation des rendez-vous destinée à améliorer l’allocation des ressources et la gestion des agendas tout en respectant des contraintes organisationnelles complexes.Société Générale est un groupe bancaire intégré majeur, présent à l’international et engagé dans des démarches de transformation digitale continue, notamment via l’exploitation d’algorithmes et de technologies innovantes afin d’améliorer l’efficacité opérationnelle de ses services.Contexte du projet :Dans un contexte où les flux de rendez-vous et de réunions doivent être gérés de manière efficace et conforme aux spécificités organisationnelles, la Société Générale a souhaité disposer d’une plateforme permettant de planifier automatiquement les créneaux tout en optimisant le taux de remplissage des agendas, évitant ainsi le recours à des call centers dédiés et anticipant l’évolution des règles métier.Objectifs du projet :Concevoir une application métier intelligente d’optimisation de planning.Permettre une allocation automatique des rendez-vous conforme aux contraintes organisationnelles.Optimiser le taux de remplissage des agendas tout en offrant une solution générique et adaptable.Réduire la dépendance à des services de support spécifiques (comme un call-center) pour la prise de rendez-vous.Défis techniques et organisationnels :Formaliser et intégrer les contraintes organisationnelles complexes dans un système automatisé.Concevoir une solution flexible, évolutive et applicable à différents contextes d’usage.Approche de co-conception :Eurelis a conduit ce projet en étroite collaboration avec les équipes internes de la Société Générale afin de comprendre les règles métier et les besoins spécifiques de planification. L’approche a reposé sur :La traduction des règles d’organisation en contraintes techniques exploitables.La conception d’une architecture capable de gérer intelligemment ces contraintes.Solution technique et expertises mobilisées :La plateforme développée par Eurelis repose sur une architecture Cloud moderne (Google Cloud) et des technologies sélectionnées pour leur scalabilité et leur performance :Backend Python (Flask) pour l’orchestration et la logique métier.DevOps et infrastructure serverless pour une flexibilité d’usage et une scalabilité optimisée.Conception UX/UI adaptée aux besoins des utilisateurs.Intégration Outlook via ICS pour synchronisation des agendas existants.Expertises mobilisées : définition de produit, conception UX/UI, maîtrise d’œuvre, développement backend & frontend, architecture et sécurité.Résultats et bénéficesUne solution d’optimisation des plannings intégrée capable de gérer automatiquement la prise de rendez-vous selon des contraintes variées.Flexibilité d’usage maximale grâce à l’architecture serverless et au déploiement Cloud.Une réduction significative du besoin en organisation manuelle et en support dédié pour la gestion des agendas.

Barnes International

Barnes International : Étude Marketing Automation Barnes International, agence immobilière de prestige, a été accompagnée dans l’étude et l’implémentation d’une solution de Marketing Automation. Ce projet a été mené en parallèle de la refonte de leur site internet et de la création de Barnes Data, leur datalake interne. L’objectif était d’optimiser la stratégie marketing de l’entreprise et de fluidifier ses processus opérationnels. Objectifs Revoir et redéfinir les personas marketing. Analyser et adapter le modèle de données Barnes Data. Recommander, sélectionner puis intégrer un outil adapté de Marketing Automation (Hubspot), et le synchroniser avec leur datalake. Optimiser et centraliser les workflows marketing pour rendre les processus plus efficaces. Défis Utilisation de multiples outils pour des actions marketing majoritairement manuelles. Difficultés de connexion entre Hubspot CRM et d’autres solutions. Assurer la cohérence des données à travers diverses plateformes. Gestion d’une base de 450 000 contacts répartis entre Brevo et des fichiers Excel. Nécessité de fusionner et redéfinir les personas afin d’assurer une segmentation optimale. Solutions apportées Mise en place d’un CRM Hubspot entièrement personnalisé. Connexion et synchronisation du CRM avec le datalake via Make. Définition et optimisation de plus de 20 workflows automatisés, représentant plus de 35 000 opérations mensuelles. Configuration d’un plan de tracking web pour affiner la mesure des performances. Unification et synchronisation des propriétés de contact et des bases de données. Rationalisation des campagnes publicitaires et des réseaux sociaux. Mise en place de sessions de formation dédiées aux équipes.

Paris s’impose comme le hub incontournable de la data en France. Pour les entreprises, collaborer avec une agence data à Paris, c’est accéder à la pointe des expertises en data marketing, web analytics, IA et gestion des données afin de transformer les performances business. Pourtant, choisir la bonne agence requiert méthode et exigence.

Dans cet article, découvrez les services clés d’une agence data marketing, les critères décisifs de sélection, des exemples concrets d’accompagnement et les grandes tendances parisiennes du secteur.

Une bonne agence data couvre un large panel de services – tout en proposant une approche sur-mesure selon votre maturité digitale et vos enjeux métiers.

| Service | Objectif | Livrables attendus |

|---|---|---|

| Data Strategy | Définir une stratégie data alignée sur les défis business | Roadmap, audit, gouvernance des données |

| Analytics & Web Analytics | Mesurer, suivre et optimiser la performance digitale | Tableaux de bord, custom tracking, reporting |

| Data Engineering / Big Data | Collecter, organiser et pérenniser les données | Déploiements cloud, ETL, architectures robustes |

| Activation Marketing | Segmenter, personnaliser et activer les données | Scoring, campagnes ciblées, automatisations |

| Data Science & IA | Valoriser et prédire grâce aux algorithmes | Prédictions, modèles d’IA, analyses avancées |

| Formation & Acculturation | Monter vos équipes en compétence data | Parcours de formation, ateliers, coaching |

Conseil pro

Un accompagnement de bout en bout – de la stratégie à l’activation – est le meilleur gage de cohérence et d’impact sur vos résultats marketing.

Face à une offre abondante, la sélection d’un partenaire data performant repose sur des critères précis, au-delà des simples références.

| Critère | Pourquoi c’est clé | Questions à poser en RDV |

|---|---|---|

| Expertise sectorielle | Adaptation à vos enjeux métier et réglementaires | Quels clients similaires ? |

| Capacité technique | Maîtrise des stacks (cloud, BI, IA, analytics) | Quelles certifications ? |

| Data-driven mindset | Culture de la mesure, pilotage par la donnée | Méthodes de test & learn ? |

| Accompagnement | Support dans la conduite du changement | Formation / coaching inclus ? |

| Reporting & ROI | Visibilité sur la valeur apportée | KPIs de suivi proposés ? |

Insight terrain

Les agences les mieux notées à Paris conjuguent compétences techniques et pédagogie pour accélérer la montée en compétence des équipes internes – un point souvent négligé.

Insérer ici des exemples facilite la projection. Paris concentre de nombreuses transformations réussies, du retail à la finance.

| Secteur | Problématique clé | Solution déployée | Résultat mesuré |

|---|---|---|---|

| E-commerce | Augmenter le taux de conversion | Implémentation d’une DMP, scoring clients | +17% taux de transfo |

| Assurance | Optimiser la détection de fraude | Modèle prédictif basé IA et big data | -25% fausses alertes |

| Services B2B | Industrialiser le reporting commercial | Automatisation (BI, dataviz) | -60% temps de reporting |

Le chiffre à retenir

80% des entreprises parisiennes ayant structuré leur gouvernance data constatent une croissance accélérée de leurs principaux KPIs.

Paris vit une accélération de la sophistication des enjeux data, portée par l’IA et la personnalisation.

Conseil pro

Ne vous limitez pas à l’effet « vitrine » : privilégiez les acteurs capables de partager des résultats mesurables et de challenger votre organisation sur la culture data.

La donnée, à Paris comme ailleurs, n’a de valeur que si elle est activée dans la durée, aux côtés des bons partenaires. Or, la maturité et la pédagogie de l’agence feront toute la différence dans le succès de votre projet.

Vous cherchez un partenaire technique mais ne savez pas par où commencer ? Voici les réponses aux questions les plus courantes.

À Paris, le secteur de la data concentre plus de 21 000 professionnels, dont une majorité de data scientists, data engineers, analysts et consultants spécialisés. La capitale bénéficie d’un écosystème académique dense avec des écoles telles que l’ENS, Polytechnique ou l’EPITA, et accueille aussi Station F et Paris&Co, amplifiant l’offre de talents hautement qualifiés. Les agences locales recrutent fréquemment des profils maîtrisant Python, R, Spark, ainsi que des experts en BI (Power BI, Tableau). Le salaire moyen d’un data scientist junior à Paris tourne autour de 45 000 € brut/an, dépassant 65 000 € pour un profil confirmé, soit près de 20 % au-dessus de la moyenne nationale. Les grandes entreprises tech implantées (BlaBlaCar, Doctolib) attirent également des talents, tirant vers le haut l’expertise du marché parisien. De nombreuses agences collaborent avec des laboratoires publics ou privés pour innover, notamment en IA et machine learning, ce qui positionne Paris comme la première ville française en matière d’innovation data.

Le coût d’un projet data confié à une agence à Paris varie fortement selon la complexité et la technicité requise. Pour un diagnostic ou une prestation exploratoire, les tarifs débutent autour de 8 000 à 12 000 €. Les projets structurants (mise en place d’un data lake, déploiement d’une BI avancée) s’échelonnent généralement entre 30 000 et 150 000 €. Paris héberge près de 400 agences data et consulting tech, dont beaucoup interviennent auprès de PME industrielles d’Île-de-France et de grands groupes bancaires. Ce tissu dense permet à la fois une variété d’offres – du sur-mesure à l’offshore – et une pression sur les salaires : 52 % des agences déclarent des difficultés à recruter, ce qui impacte les prix. Les clients typiques sont les ETI, grands comptes, startups SaaS et collectivités territoriales, chacune ayant des budgets distincts, mais un point commun : à Paris, la qualité de la prestation justifie un tarif souvent 15 à 25 % supérieur à celui d’autres métropoles françaises.

Les agences parisiennes interviennent principalement sur des infrastructures cloud (AWS, Azure, GCP), outils de traitement Big Data (Spark, Hadoop), et des environnements d’analyse avancés (Python, R, SQL). Plus de 70 % des projets impliquent des plateformes BI telles que Power BI, Tableau ou QlikSense, portés par la demande croissante de pilotage en temps réel. L’essor de l’intelligence artificielle est aussi net : 48 % des agences déclarent avoir livré au moins un projet IA / machine learning en 2023. Par ailleurs, le secteur bénéficie de la proximité de l’Institut PRAIRIE ou de Sorbonne Université pour la recherche appliquée. Paris compte plus de 3 200 entreprises tech, dont les géants du CAC40, qui tirent la sophistication technique des solutions développées en agence, avec une forte dominante sur la data gouvernance et la conformité RGPD.

Le marché parisien de la data est largement tiré par les grands comptes du secteur bancaire, assurance, santé et distribution, mais on observe une forte progression des PME industrielles et du secteur public. Plus de 60 % des ETI franciliennes externalisent au moins une partie de leurs besoins data. Les usages sont variés : optimisation des chaînes logistiques, automatisation de la relation client (CRM), détection de fraude, analyse comportementale ou encore prédictions de ventes. Le secteur bénéficie d’une dynamique particulière avec la présence de plus de 1 200 startups data à Paris, notamment dans les domaines de la cybersécurité, l’IoT ou la finance (fintech). La diversité de la demande favorise l’émergence de projets sur-mesure, allant de la simple visualisation à l’intégration de systèmes IA embarqués dans l’industrie ou la santé. L’Etat et de grandes collectivités d’Île-de-France sont aussi des donneurs d’ordre importants, notamment dans la gestion des données urbaines et la digitalisation des services.

La durée d’un projet data confié à une agence parisienne dépend fortement de son envergure. Les études de cadrage ou prototypes (POC) s’étalent sur 4 à 6 semaines, tandis qu’un projet de déploiement de plateforme BI ou d’architecture Big Data requiert généralement de 3 à 9 mois, incluant les phases d’analyse, développement, recette et accompagnement au changement. Selon la CCI Paris Île-de-France, 38 % des missions dépassent les 6 mois, particulièrement dans la finance et l’industrie où l’intégration avec les systèmes existants rallonge les délais. La densité du tissu industriel parisien (plus de 70 000 entreprises tech recensées) introduce aussi des projets longs, structurés autour de la transformation numérique globale. Les agences locales sont habituées à composer avec cette exigence de rapidité et de qualité, dans un contexte où la pénurie de ressources qualifiées à Paris peut occasionner des délais supplémentaires pour les expertises rares.

Le marché parisien de l’emploi data est sous tension : près de 56 % des agences déclarent des difficultés à recruter data scientists et engineers. Pour pallier cette pénurie, elles s’appuient sur un vivier exceptionnel issu d’écoles reconnues comme Télécom Paris, CentraleSupélec ou l’ENSAE, ainsi que sur des partenariats avec les pôles de compétitivité Cap Digital et Paris-Saclay. Les salaires sont à la hausse : un data engineer débutant avoisine les 42 000 €/an brut, montant à plus de 75 000 € pour un senior – soit 10 à 15 % au-dessus de la moyenne nationale. Le recours à des formats plus flexibles (freelance, remote national voire international) tend à croître, représentant près de 20 % des recrutements. Les agences investissent également dans la formation continue pour fidéliser leurs équipes, profitant du dynamisme local en matière de MOOC et d’événements (DataJob, Paris AI Week).

Paris est dotée d’un écosystème d’innovation exceptionnel dans la data. Station F, plus grand campus de startups au monde, héberge plus de 150 jeunes pousses orientées IA, big data ou BI. Cap Digital, principal cluster français du numérique, fédère plus de 1 000 membres sur la région, offrant un terrain privilégié pour les collaborations entre startups, grands groupes (AXA, Orange) et instituts de recherche. Paris&Co soutient via ses incubateurs des projets data appliqués à la smart city, la finance ou la santé. L’Université PSL et Sorbonne Université sont aussi des acteurs majeurs dans la formation et le transfert technologique. Cette dynamique se traduit par une croissance annuelle de plus de 8 % des startups data à Paris, qui représentaient déjà plus de 15 % des créations d’entreprises numériques franciliennes en 2023. Cette concentration de structures d’accompagnement et d’innovation renforce la compétitivité des agences locales.

Le marché parisien des agences data est radicalement transformé par l’essor de l’intelligence artificielle, avec une hausse de +25 % des investissements dans l’IA depuis 2022 dans la métropole. La maîtrise de la gouvernance des données, stimulée par le respect du RGPD et l’essor de la souveraineté numérique, est une priorité explicitée par plus de 40 % des décideurs locaux lors des événements tels que le Paris Data Summit. La montée en puissance de l’analyse prédictive dans le retail et la santé, favorisée par un tissu hospitalier et commercial dense (plus de 1 500 établissements de santé, 10 000 commerces), crée une forte demande. La recherche d’efficacité dans les chaînes industrielles (jusqu’à 18 % de gain de productivité lié à la data, selon la Métropole du Grand Paris) motive également les investissements. Enfin, la demande croissante pour des solutions éthiques et responsables façonne les offres, dans un contexte concurrentiel où la capitale concentre près de 30 % de l’ensemble des agences data françaises.